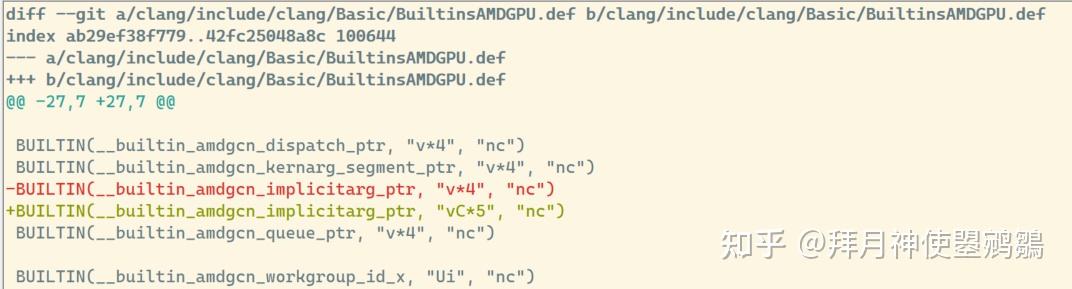

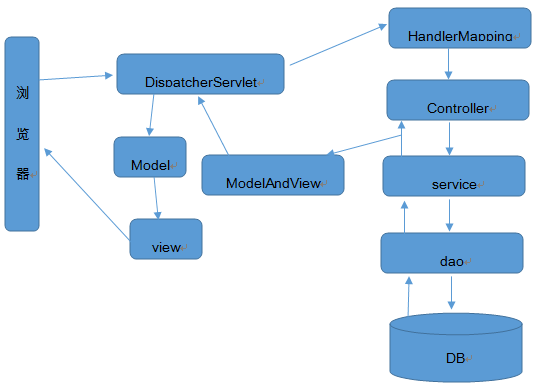

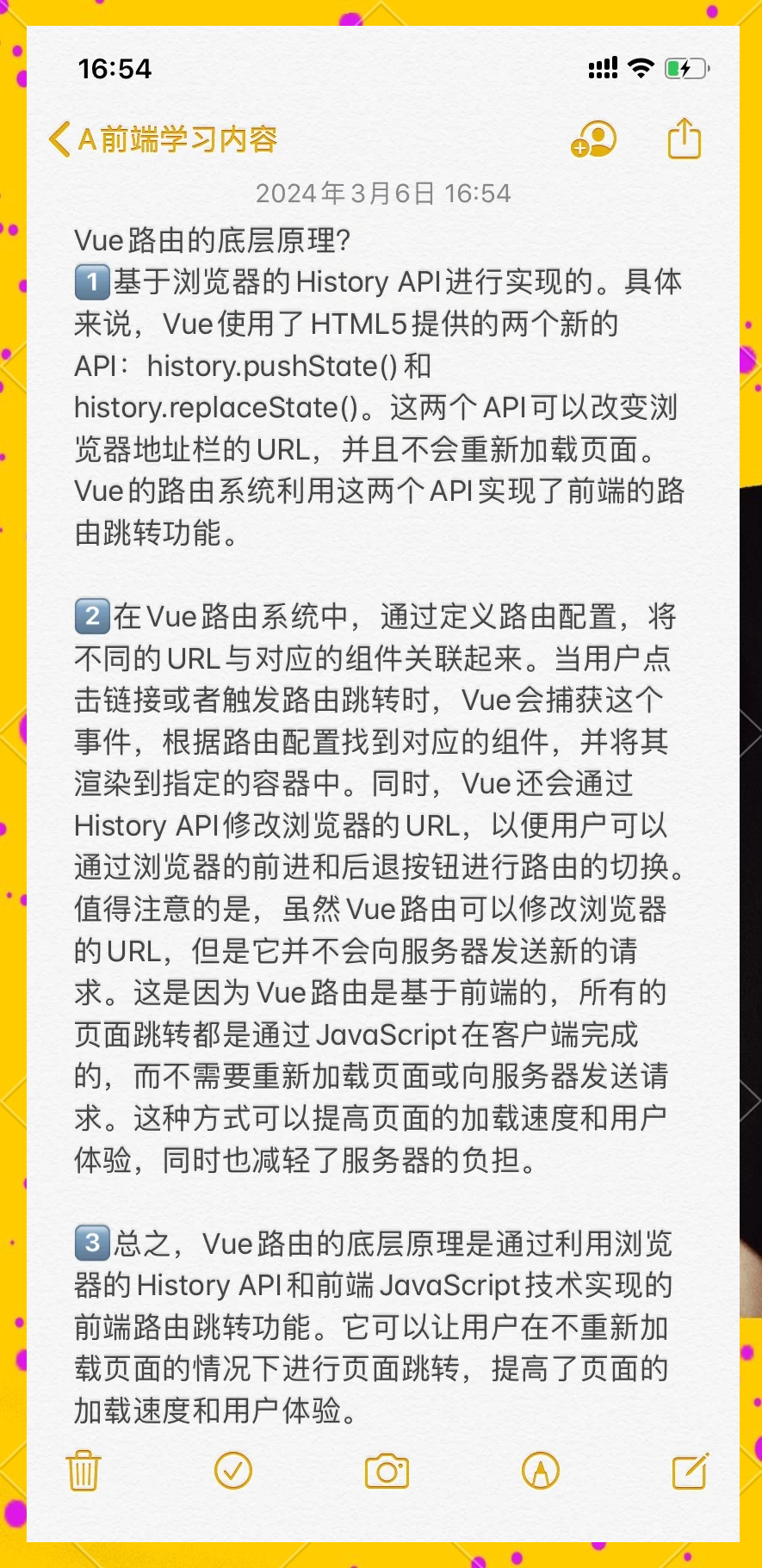

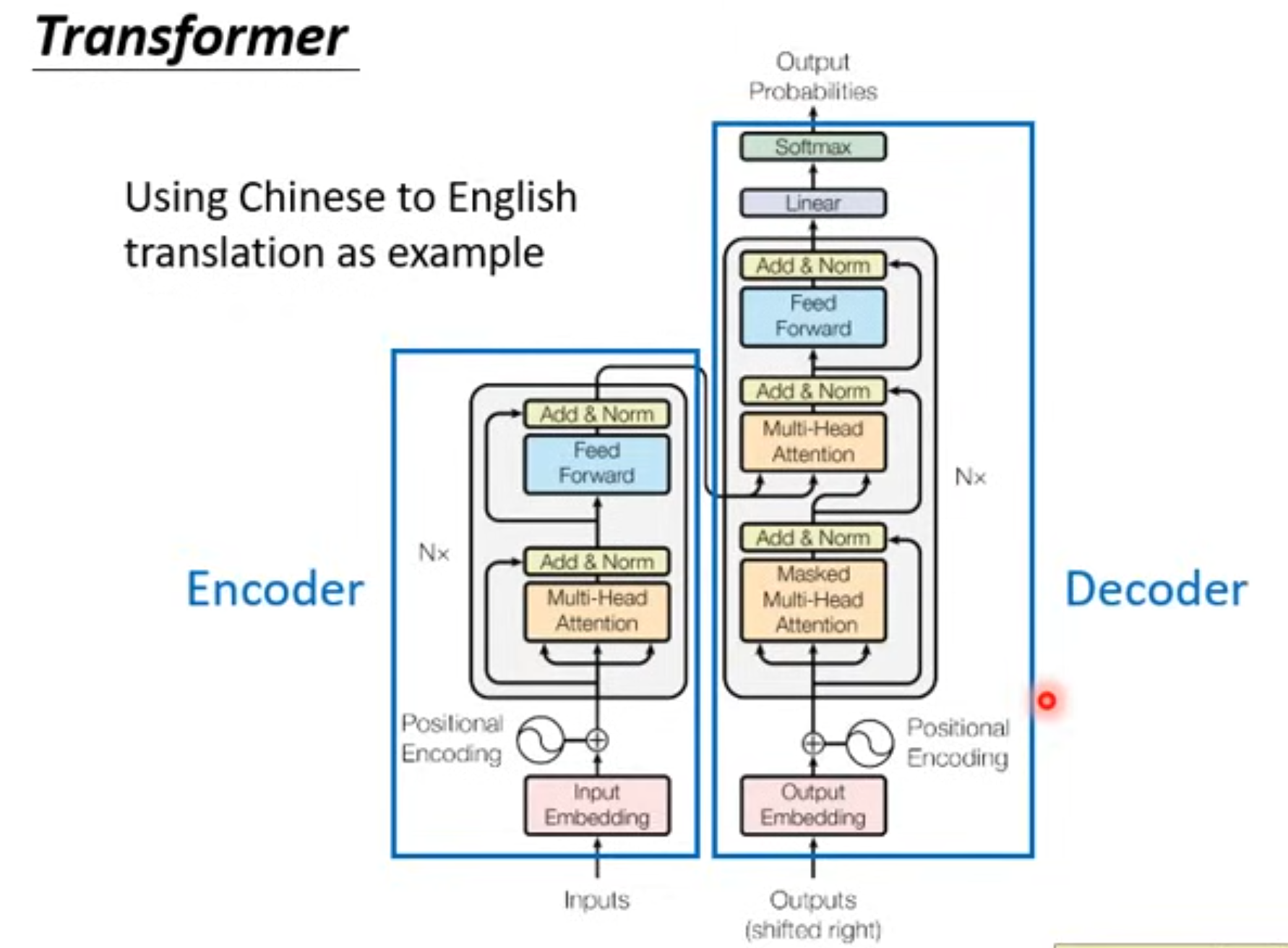

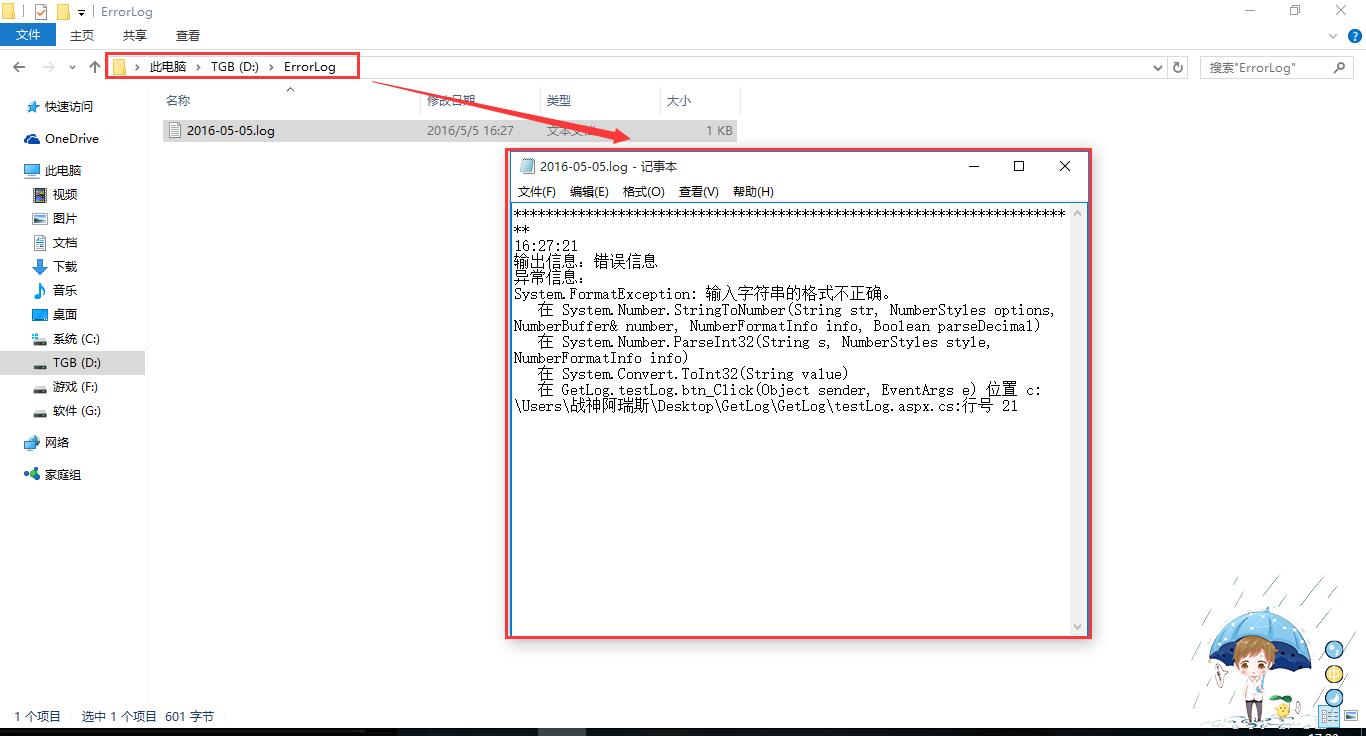

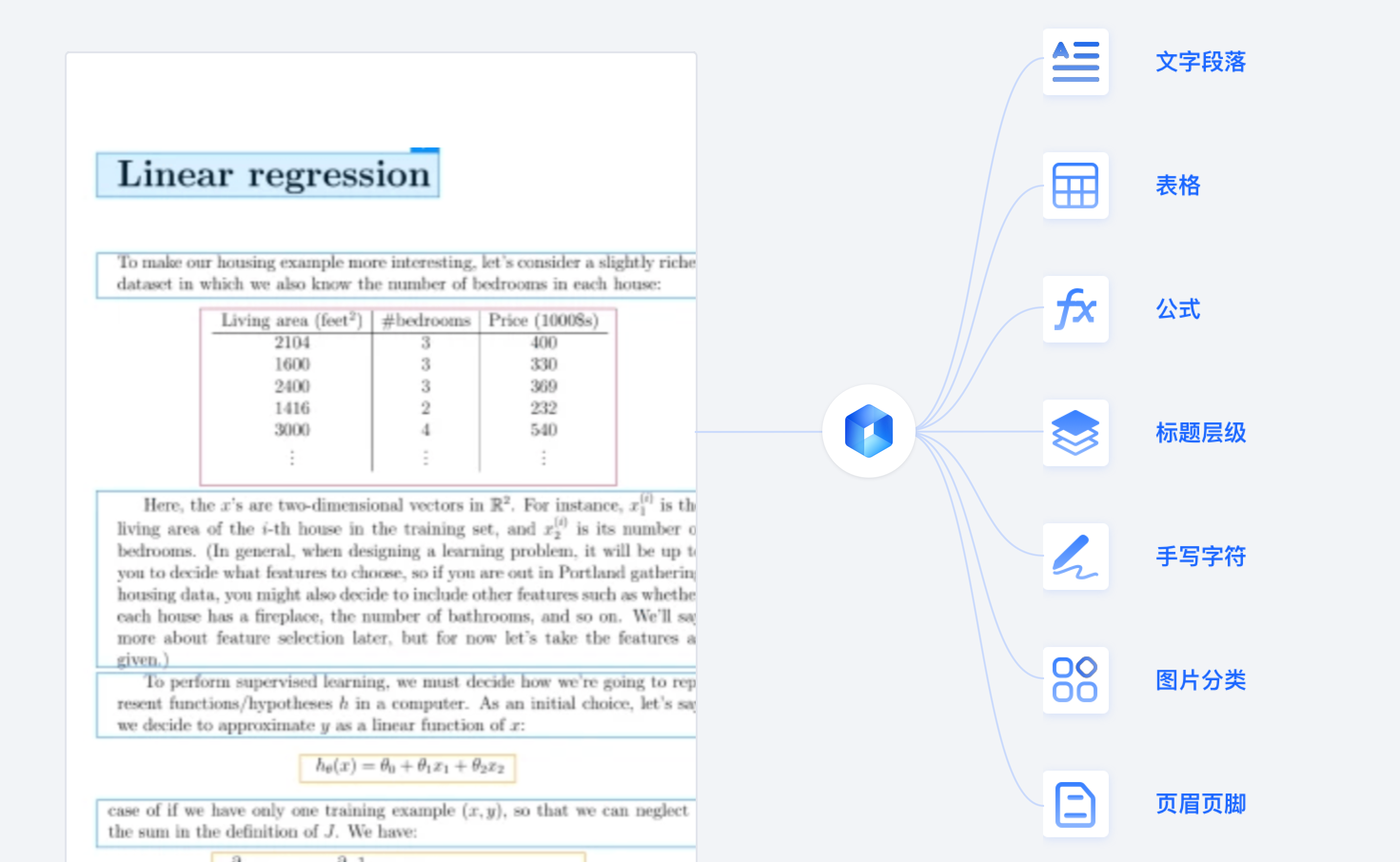

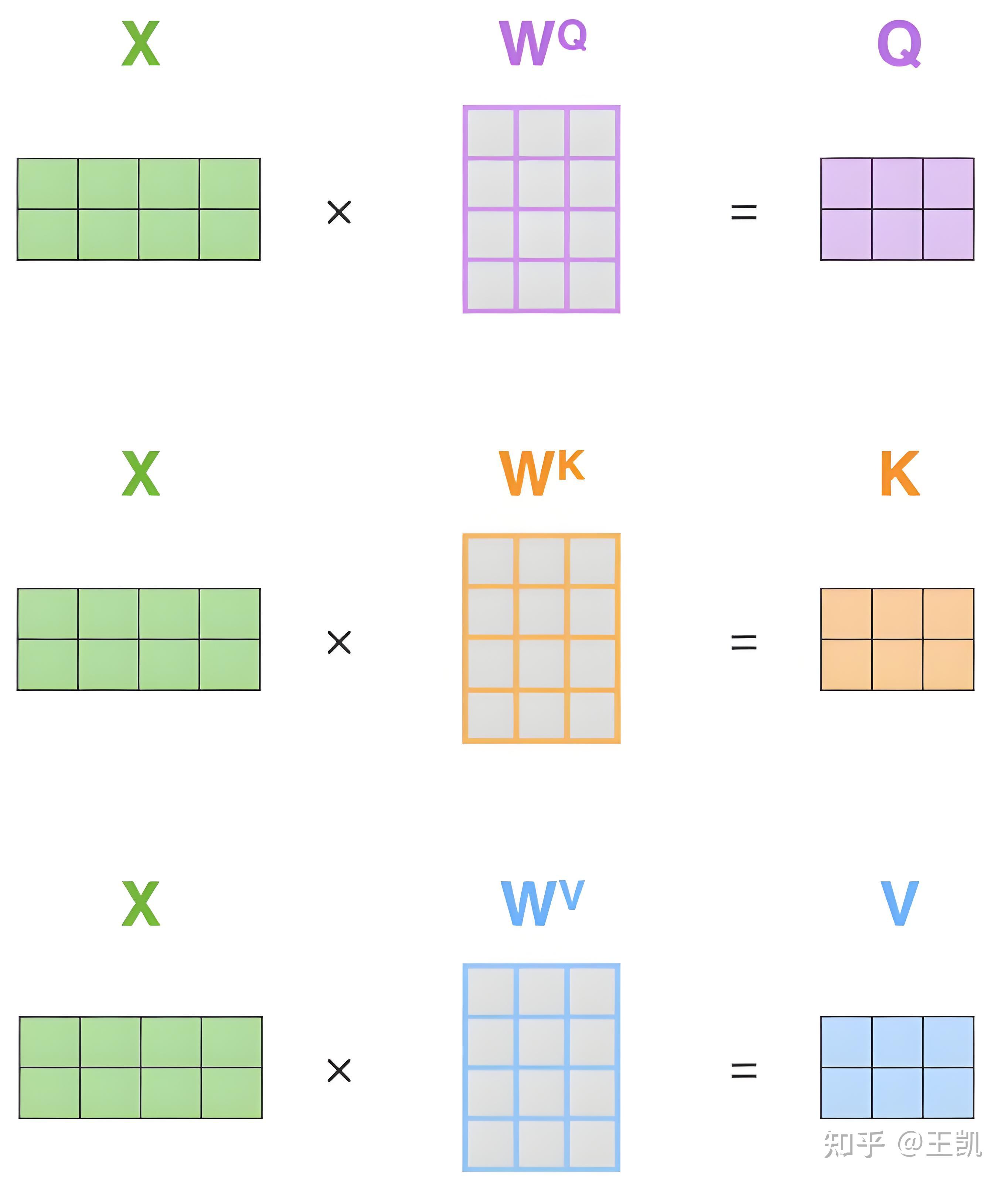

使用huggingface镜像下载sentence transformer 下载natural language tool kit NLTK 搭建知识库收集数据HuggingFace:Transformer库使用,通过代码仓库中HuggingFace:Transformer库使用的文本文件进行操作 筛选txt和md文件HuggingFace:Transformer库使用,确保数据的高效利用 文本加载和预处理,利用LangChain提供的FileLoader对象加载目标文件,提取纯文本内容 文本向量化,通过langchain文本分块工具配合sentence。

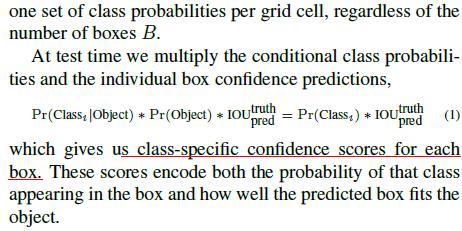

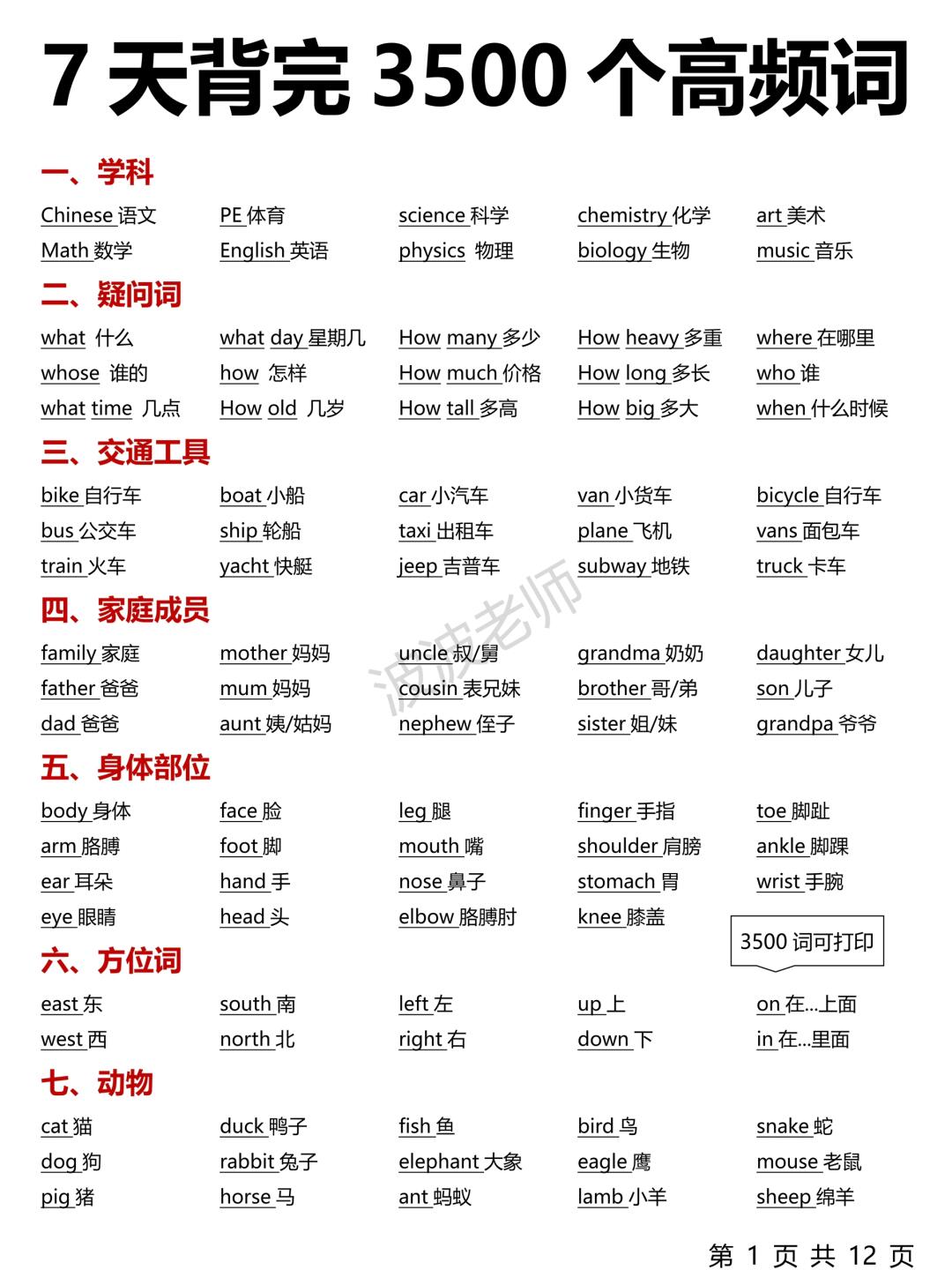

在使用Transformer模型处理文本时,常会添加一些特殊token来表示特定含义,例如利用prompt提升LLM在下游任务的性能Bert预训练文本中,CLSSEPUNKPAD等为默认的特殊token这些特殊token加入词汇表后,能避免在切词时将其拆分,确保整个token保持完整在Bert文本表征中,若需额外。

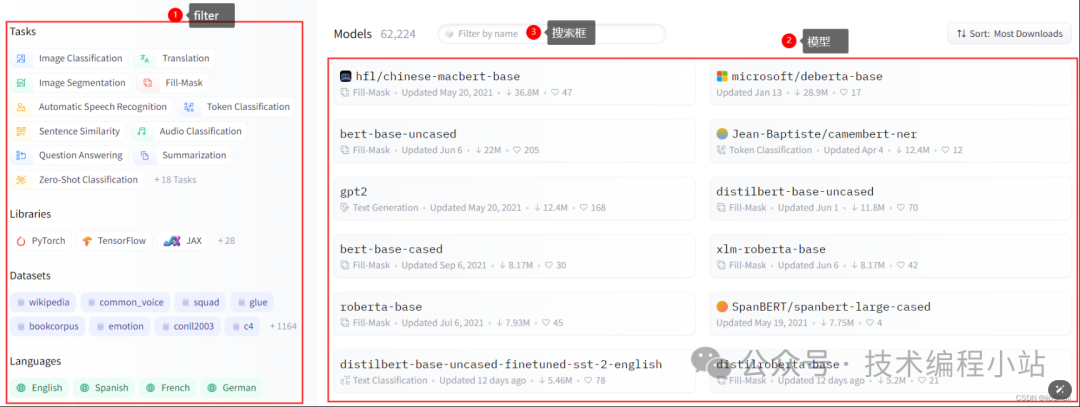

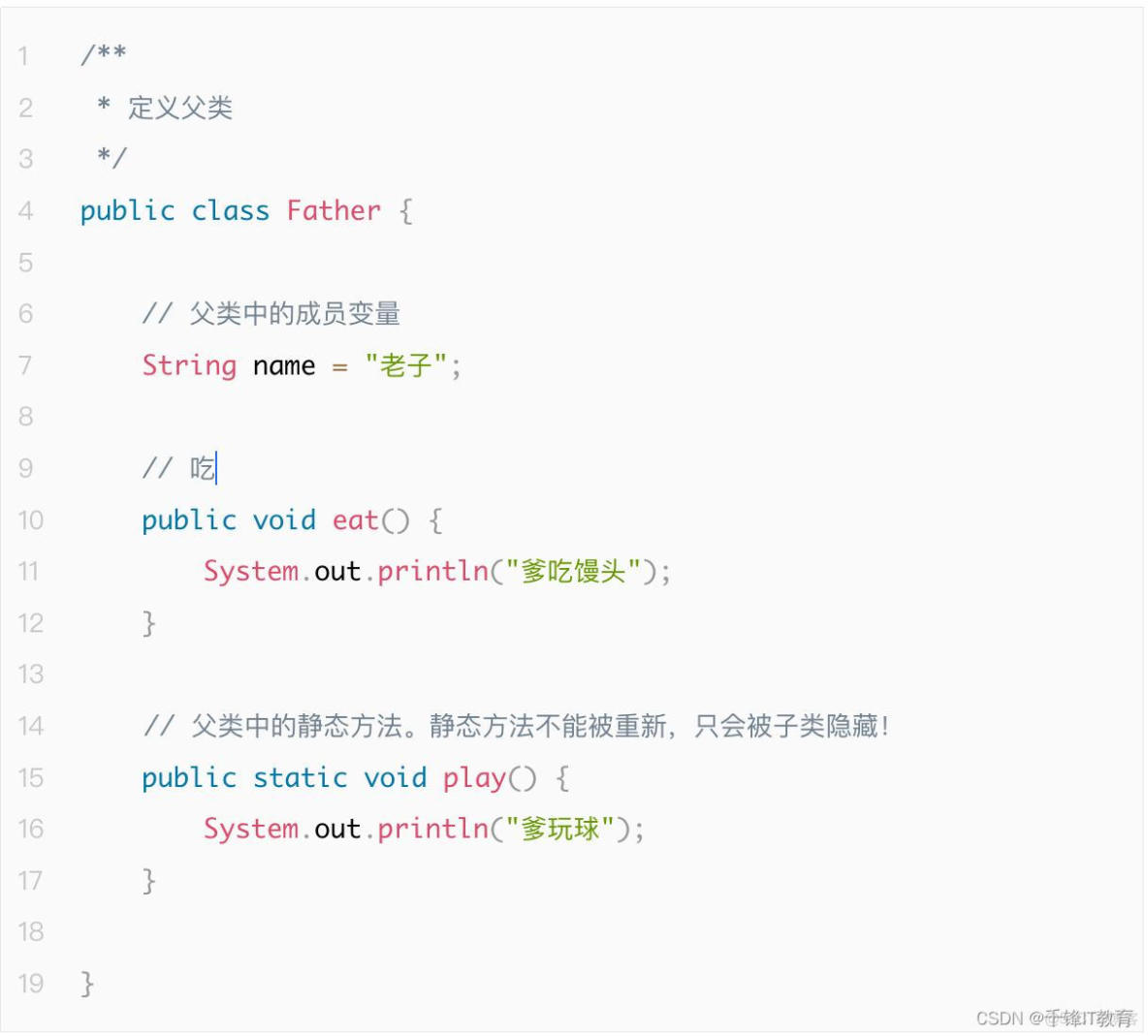

BERT的使用 在各个任务中,BERT的使用主要是通过添加输出层具体实现时,可以利用huggingface的Transformers库,内置预训练模型和封装任务,降低使用成本总结 BERT通过结合双向上下文表示掩码语言模型和下一个句子预测策略,有效提升自然语言处理任务的性能,并通过预训练和微调策略,简化模型的适应性与应用。

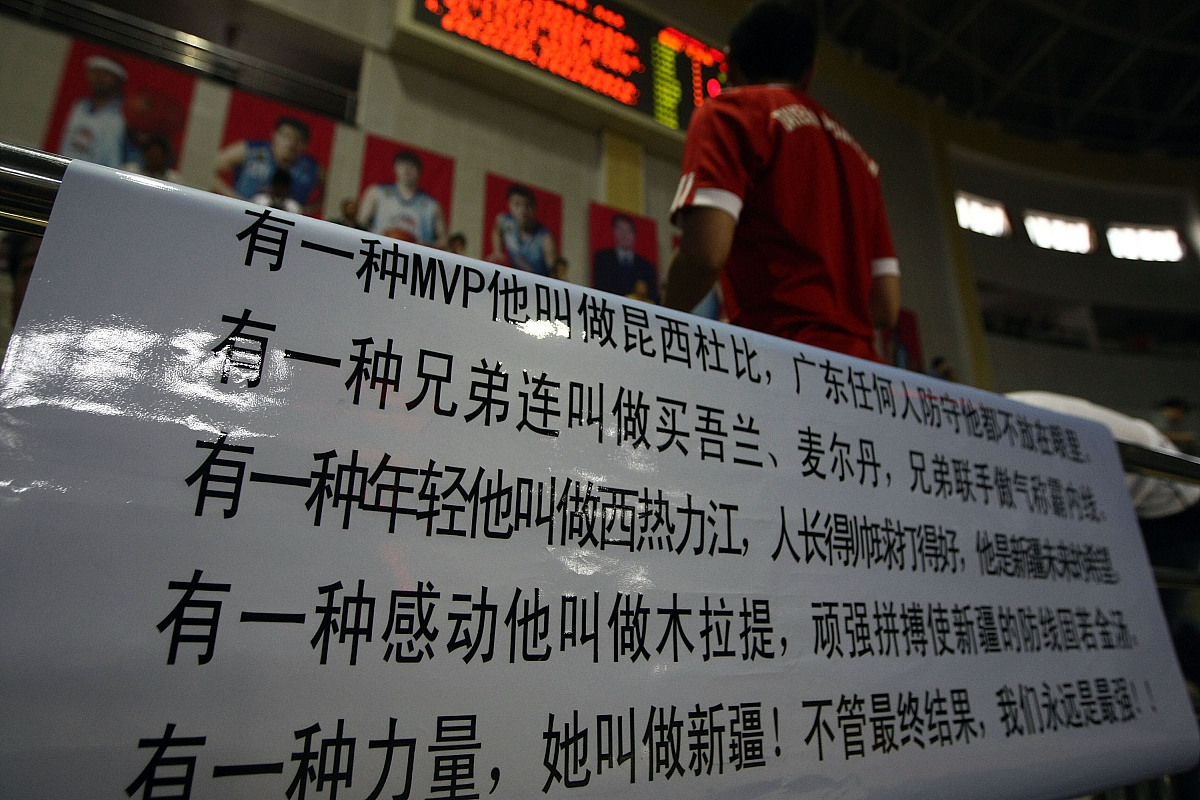

网友评论

最新评论